Qué dice la ley de los videos de TikTok en primera persona creados con inteligencia artificial

Si sólo tienes unos segundos, lee estas líneas:

- En TikTok hay cuentas especializadas en difundir videos que cuentan historias de crímenes, fallecimientos, desapariciones o sucesos desconcertantes con el supuesto protagonista mirando a cámara.

- Aunque las historias se cuentan en primera persona, no hay personas reales en esos videos: son contenidos generados con inteligencia artificial.

Los protagonistas de las historias que se narran o sus familiares pueden interponer demandas contra los creadores y distribuidores de los mismos si estos dañan su reputación con sus falsas representaciones

“Morí al caer en un pozo que se había construido sin permiso”. “Desaparecí adentro de mi propia habitación y mi cuerpo fue encontrado sin vida 9 días más tarde”. “Tenía un destino brillante en el mundo del boxeo, pero mi vida y carrera fueron destruidas”. Estos son algunos de los videos que circulan en TikTok que cuentan historias, generalmente trágicas de crímenes, fallecimientos, desapariciones, sucesos extraños o personajes históricos.

Todos los contenidos comparten características. Se trata de videos creados con inteligencia artificial a partir de una imagen generada con IA que se anima para dar movimiento al rostro. La voz está automatizada y no es real. Y quizá lo más desconcertante: en todos ellos se narran en primera persona historias reales (más o menos exageradas) de sucesos trágicos o misteriosos, como si las víctimas (cuyas imágenes han sido generadas por inteligencia artificial y suelen estar inspiradas en su físico real) nos los contaran directamente.

Estos videos cuentan con millones de reproducciones y hay cuentas en TikTok especializadas en difundirlos. En las descripciones de estos perfiles se definen como “Historias relatadas por sus protagonistas” o “Historias contadas por los que las vivieron”.

Los protagonistas de los videos pueden interponer demandas por difamación o por falsa publicidad contra los creadores y distribuidores de los mismos si estos dañan su reputación con sus falsas representaciones.

Los videos que narran sucesos en primera persona y se difunden en TikTok están creados con inteligencia artificial

En TikTok hay una nueva tendencia cuando menos desconcertante. Se trata de cuentas que comparten videos en los que, mirando a cámara, una persona te cuenta un suceso de su vida. Todos estos contenidos comparten características. Son historias truculentas sobre crímenes, fallecimientos, desapariciones y sucesos extraños, que se cuentan con palabras llamativas y trágicas. Buscan, claro, que no apartes la vista. En otras ocasiones, los personajes narran episodios de la vida de personajes históricos o famosos.

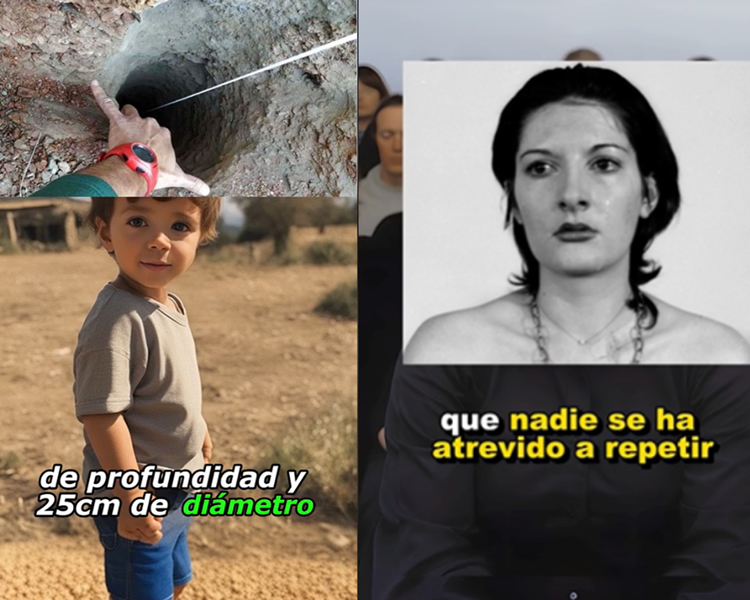

Aunque las historias se cuentan en primera persona, no hay personas reales en esos videos. Lo que aparecen son imágenes generadas con inteligencia artificial (todas con el mismo estilo, rostros simétricos, pieles de porcelana, pupilas muy circulares) en las que el cuerpo permanece estático y la cabeza, los labios y los ojos se mueven. Hay detalles concretos de las imágenes que indican que están generadas con IA, como manos deformes. Estas imágenes en movimiento generadas con IA se intercalan y superponen con fotografías reales de los sucesos que se están contando

A la izquierda, video sobre Julen Roselló, un niño que cayó por un pozo en 2019 en España, en el que se observan deformidades en los dedos de la mano. A la derecha, imagen real de la artista Marina Abramović superpuesta que se utiliza en un momento de otro de los videos generados con IA.

El otro detalle es la voz. En los videos los protagonistas cuentan la historia con voces automatizadas generadas también con inteligencia artificial (es lo que se conoce como voces sintéticas). Por tanto, estos contenidos están creados con IA y no son reales, algo que en algunos casos se avisa y, en otros, no. Los videos se agrupan bajo hashtags como #aistorytelling en inglés (16,2 billones de visualizaciones), y en castellano suelen usar otros como #casosdelavida (897,1 millones visualizaciones), #historiareal, #historiasreales o #casosdelavidareal.

Las historias que se cuentan son de personas reales, en muchos casos de menores de edad

Aunque los videos están creados con imágenes falsas, las historias que hay detrás sí son reales, aunque a veces están más o menos adornadas o exageradas y, en algunos casos, presentan datos incorrectos. Uno de los videos más virales (ahora eliminado, pero que llegó a acumular 67 millones de reproducciones) fue sobre Suleman Dawood, el hijo de 19 años del millonario paquistaní Shahzada Dawood, quien falleció junto a su padre en la expedición submarina al Titanic.

Hay videos de todo tipo, como la historia del experimento de la artista serbia Marina Abramović o del derrame cerebral del boxeador Prichard Colón. En los comentarios de este tipo de contenidos, algunos usuarios señalan errores en lo que se cuenta y se cuestionan el sentido del video.

Muchos de estos videos cuentan historias de menores de edad y de niños y niñas que fallecieron. El video sobre Julen Roselló; la desaparición y fallecimiento de Paulette Gebara, una niña mexicana de 4 años; la historia de Terry Jo Duperrrault y los asesinatos en el velero Bluebelle; y de Michael Dumas, un adolescente que contrajo anquilostomas en la playa. No son historias precisamente amables, pero con el tono y el dramatismo consiguen enganchar a la gente y sumar millones de reproducciones.

¿Es legal que se haga un contenido contando la historia real de alguien en primera persona sin su permiso?

Aquí viene el quid de la cuestión. Como hemos dicho, estos videos representan al protagonista con una imagen generada con inteligencia artificial y ponen en una voz falsa su historia, como si la contara a cámara. ¿Es legal hacerlo sin pedir consentimiento al protagonista, que no ha buscado serlo?

Desde Factchequeado le hemos preguntado sobre estos videos a David Greene, abogado senior y director de libertades civiles de la Fundación Frontera Electrónica (EFF, por sus siglas en inglés).

“Según la legislación estadounidense, muchos discursos siguen estando protegidos, sobre todo si no causan perjuicios económicos u otros daños perceptibles”, comenta el experto.

Según cuenta, a menos que estos videos formen parte de una transacción comercial fraudulenta (es decir, si alguien paga por ellos pensando que recibe videos auténticos), es probable que no sean ilegales, siempre que no aborden algún tema específico protegido por la ley. Es decir, no podrían ser objeto de un proceso penal.

No obstante, las personas que aparecen en los videos (o los sujetos creados con inteligencia artificial) o sus familiares “pueden interponer demandas civiles contra los creadores y distribuidores de los videos si éstos dañan su reputación por sus falsas representaciones”.

“Es probable que se trate de demandas por difamación o falsa publicidad, dependiendo de la legislación estatal”, señala. Si los videos se monetizan o comercializan de alguna manera, Greene explica que los afectados pueden tener derecho a reclamar por publicidad.

Algunas de estas reclamaciones dependerán de que los videos sean intencionadamente engañosos, como indica Greene: “Si están claramente etiquetados como inteligencia artificial, en lugar de como videos auténticos, será muy difícil ganar las demandas basadas en la falsedad”.

En Factchequeado también te hemos explicado cuáles son nuestros derechos si utilizan nuestra imagen en un ‘deepfake’ sin nuestro consentimiento.

Factchequeado es un medio de verificación que construye una comunidad hispanohablante para contrarrestar la desinformación en Estados Unidos. ¿Quieres ser parte? Súmate y verifica los contenidos que recibes enviándolos a nuestro WhatsApp +16468736087 o a factchequeado.com/whatsapp.

Leer más: